На что влияет видеопамять видеокарты в играх

Объем видеопамяти

Объем видеопамяти – суммарная емкость памяти видеокарты, которая хранит изображение для вывода на монитор. Не всегда большой объем видеокарты говорит о ее высокой производительности. Это лишь маркетинговый ход, поэтому нужно обращать внимание и на другие важные характеристики (тип памяти, разрядность шины и тд) при выборе видеокарты.

Функция видеопамять не отличается от «обычной» памяти, которую использует ваш ПК. Она встроен в видеокарту и использует более быстрые типы оперативной памяти, такие как GDDR5, GDDR5X, HBM2 и GDDR6.

Сколько нужно видеопамяти

Это зависит от того, как вы будете использовать компьютер. Рассмотрим на примере игровых ПК и узнаем, сколько потребляют современные игры видеопамяти.

Каждая настройка в игре будет занимать определенное количество видеопамяти, но наиболее требовательными являются:

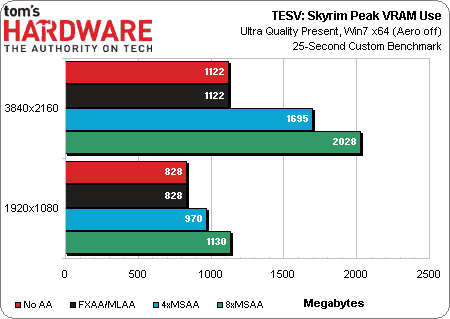

Сегодня рендеринг под большие разрешения монитора является наиболее прожорливым параметром. Раньше текстуры и дальность прорисовки тоже были проблемой, но с увеличением объемов — это уже не то, на что стоит обращать внимание. То же самое можно сказать и про сглаживании, поскольку оно становится менее актуальным из-за все более высоких разрешений игровых мониторов.

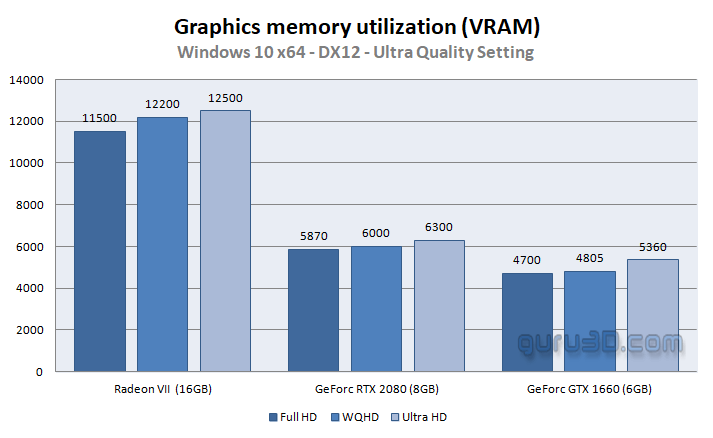

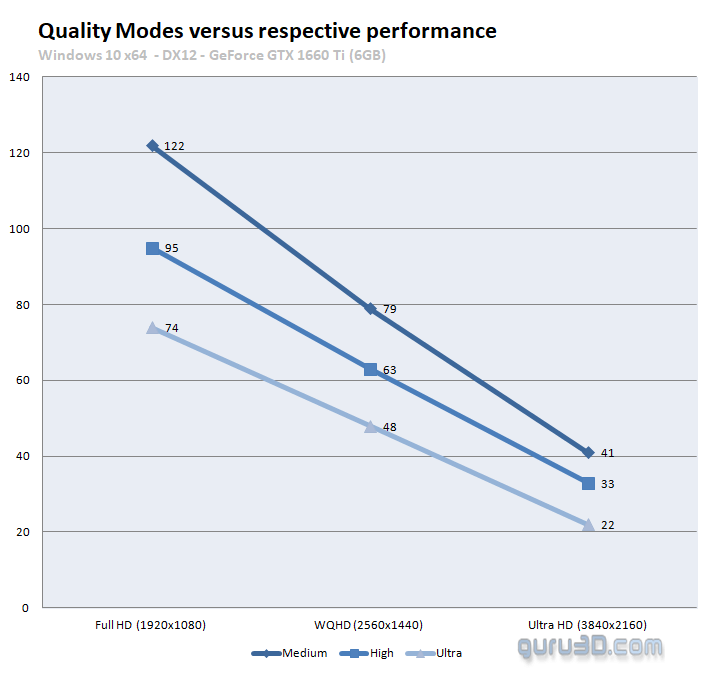

Или на примере игры The Division 2, выпущенной в 2019 году. Тестирование проводил сайт guru3d.com. Настройки качества изображения — ультра, для 3-х разрешений экрана.

Игра заполняла видеопамять насколько это было возможно, с небольшим запасом. В зависимости от видеокарты этот объем был от 6 ГБ до 11 ГБ, т.е. использовался максимально доступный VRAM. С заполненной графической памятью вы не заметите лагов. Но… Посмотрим на график производительности:

Какую видеокарту с каким объемом памяти выбрать

Как было написано выше, разрешение является основным фактором при выборе видиокарты.

В продаже популярные следующие модели:

Для современных игр (2020 года, на момент написания) необходимые следующий объем памяти видеокарты:

Указанный объем для современных игр с настройками качества «Ультра». К онечно, вы можете играть на 4K с видеокартой на 4 ГБ видеопамяти, но имейте в виду: игровая индустрия не стоит на месте. То, чего хватает сегодня, не хватит завтра, поэтому планируйте на будущее.

В итоге

Любая видеокарта с 4 ГБ видеопамяти подойдет для современных игр в любом разрешении, но не с максимальными настройками. Без предварительных тестов нельзя утверждать, что такая видеокарта сможет на максималках тянуть любую игру.

Мы рекомендуем отдавать предпочтение видеокартам с большей емкостью VRAM, то есть с 6 ГБ и более, так сказать, с перспективой на будущее.

Старые тесты

Тест проверялся на разных играх при самых высоких значениях качества графики:

В итоге были получены такие значения:

Использование видеопамяти в различных играх, Мбайт

| DirectX 9 | DirectX 10 | DirectX 11 | |

| 1680х1050 | 402-1104 | 450-993 | 721-1016 |

| 1920х1200 | 424-1137 | 518-1097 | 784-1034 |

| 2560х1600 | 733-1536 | 737-1536 | 1030-1536 |

Самой требовательной как всегда остается игра Crysis Warhead, а также Napoleon Total War, игра обошла даже Crysis.

На что влияет объем памяти видеокарты

Это не сложно проверить на одинаковых моделях видеокартах, но с разным объемом видеопамяти.

В тесте использовались одинаковые видеокарты, одного производителя, но с разным объемом памяти. Только в случае с Radeon HD 4870, наблюдается прирост производительности.

Сколько видеопамяти нужно для компьютерных игр

Видеопамять (или VRAM) — это такое же хранилище данных, как и оперативная память (DRAM) вашего компьютера. Много ли ее надо?

Вы могли заметить, что при настройке графики в играх интерфейс показывает, сколько видеопамяти потребуется при включении той и иной опции. Так вот, для комфортной игры с максимальным качеством отображения нам необходимо выяснить, сколько видеопамяти потребуется. Этим и займемся.

Что важно знать

Что произойдет, если видеопамяти все-таки не хватит?

Страшного — ничего, но впечатление от игры может быть подпорчено, особенно если вы решите поиграть в долгожданную и требовательную новинку. Ждите также проблем с производительностью и текстурами.

Что это значит?

Недостаточная емкость видеопамяти почти всегда означает проблемы с производительностью в играх. При серьезной нехватке VRAM начинает задействоваться более медленная DRAM (оперативная память ПК). В частности, это приводит к более низкой частоте кадров и незначительному притормаживанию.

Проблемы с текстурами — это, например, искажение изображения, задержки и разрывы кадров. Если у вас мало VRAM, вам придется выставлять в настройках игр более низкую детализацию текстур, чтобы при быстром перемещении по игровой карте вы не попадали в ситуацию, когда текстуры на определенном участке не успели полностью прогрузиться. В таких случаях вы вместо, допустим, домов будете видеть белые блоки, а вместо травы — пустое поле.

Сколько VRAM мне нужно для комфортной игры?

В 2021 году для комфортных игр в современные тайтлы нужно минимум 6 Гб видеопамяти. Но лучше всего рассматривать решения с 8 Гб, особенно если вы планируете играть на мониторе с разрешением 2K (1440p) или 4K (2160p). Так что когда вы задаете себе вопрос «Сколько VRAM мне вообще нужно?» — учитывайте следующие факторы:

1. Разрешение, в котором вы запускаете игры

Чем выше разрешение в игре, тем больше видеопамяти вам потребуется. Более высокое разрешение означает дополнительные пиксели, которые увеличивают размер текстуры и требуют больше памяти для ее хранения. Исходя из разрешения, требуемую емкость VRAM можно рассчитать:

Но не только разрешение изображения влияет на емкость памяти.

2. Сами игры, которые вы предпочитаете

Некоторые игры не только поддерживают высокие разрешения в 4K, но и в целом требуют больше видеопамяти. Как правило, это AAA-игры (в духе Call of Duty: Black Ops — Cold War) и игры с плохой оптимизацией (такое часто встречается при выходе новых игр, вспомним, к примеру, PUBG версии 2017 года).

Более качественная графика и количество отображаемых объектов на игровой карте также определяют, сколько памяти она использует. Например, игры с тяжелой графикой, такие как «Ведьмак 3»: Control и Shadow of the Tomb Raider требуют намного больше памяти, чем простые игры, не особо ориентированные на графику, такие как League of Legends и Counter-Strike: Global Offensive.

3. Использование графических модификаций

Иногда использование сторонних модов или графических надстроек может привести к увеличению использования видеопамяти до гораздо больших объемов, чем обычно. Это связано с тем, что некоторые моды добавляют в игры текстуры высокого разрешения (например, в The Elder Scrolls V: Skyrim или Fallout 76). Если использование модов — ваш предпочтительный способ игры, то вам, вероятно, следует рассматривать видеокарты с 6 Гб VRAM и более.

4. Сглаживание очертаний и контуров

Для сглаживания краев объектов и устранения эффекта лесенки в играх используется функция Anti-Aliasing. Чем сильнее сглаживание, тем приятнее получается картинка, однако для этого требуется отрисовать больше пикселей. Поэтому когда этот параметр включен, потребление видеопамяти также увеличивается. Степень его усиления будет зависеть от используемого метода Anti-Aliasing. К наиболее распространенным из них относятся:

5. Настройки параметров игры

Чем выше настройки вашей игры, тем больше данных требуется обработать вашему графическому процессору — и тем больше памяти он потребляет в результате. Поскольку верно и обратное, вы можете понизить настройки игры, чтобы уменьшить использование памяти.

Компромисс или новая видеокарта?

Многим игрокам с видеокартами пятилетней давности, мечтающим о новых играх, приходится снижать настройки графики таким образом, чтобы их игры работали плавно. Помните, что такие настройки, как сглаживание, уровень детализации и качество текстур, больше всего влияют на потребление VRAM (о чем мы и говорили выше).

Если подобные компромиссы вас не устраивают — воспользуйтесь нашим гайдом. В самом начале мы привели приблизительный расчет по части емкости видеопамяти, которая требуется для запуска современных игр с максимальным качеством графики, так что вы без труда определитесь с параметрами VRAM.

Дальше останется лишь выбрать на сайте «Ситилинка» модели видеокарт, удовлетворяющие вашим требованиям, и подобрать оптимальный по цене вариант.

Сколько видеопамяти нужно играм, влияние нехватки видеопамяти на производительность, Polaris 4Gb vs 8Gb.

реклама

Идея данного тестирования может показаться совершенно не новой, но это только на первый взгляд.

Все подобные тесты, что вы видели, а я уверен их было не мало, в той или иной степени не отражали действительное положение дел. Я ни в коей мере не хочу заниматься хейтерством или упрекать людей в том, как те тестируют, и какой результат получается в итоге. Просто чтобы было понятно, о чем я говорю, приведу самые известные тесты похожего характера и что с ними не так, и если мои доводы окажутся неубедительными, то смело закрываем статью, ибо вам далее читать необязательно.

«Князь» и его крестьяне. Выбрали много игр, все в разгоне по максимуму. Но проблема, конечно память на картах объемом 8 гигабайт гонится обычно лучше, и грех было не гнать ее до упора, вот только разгон памяти повышением ее частоты не дает столько, сколько дает разгон и настройка таймингов (тут все, как и с оперативной памятью, при наращивании частоты с таймингами в авто они просто увеличиваются и эффект от наращивания частоты мизерный либо его вовсе нет с видеопамятью просто меняется страп на более ослабленный по мере роста частоты). По своему опыту обращения с Polaris *70/80 скажу, что худший разгон видеопамяти наблюдался у чипов Elpida, но и те без проблем брали частоту 1950-1970MHz с ужатыми таймингами, у всех остальных производителей проблем с преодолением планки в 2000MHz не было. Даже на частоте 1900MHz можно получить ПСП выше, чем на памяти с частотой 2300MHz а в итоге только это и имеет значение. Так что, ребята, у кого память на видеокарте RX не очень гонится, просто меняем страпы и не паримся сильно по поводу частоты.

Конечно, подобный способ изменения таймингов не идеален и получить максимум от него не получится, но у него есть и свои плюсы он не требует перепрошивки биос, хотя это и не является столь трудоемким занятием.

Манипуляции с таймингами и разгон памяти дают примерно 5-10% прироста производительности в зависимости от игры, что тоже на ровном месте не валяется.

реклама

Все проделанное с видеокартой минимум поднимает производительность Polaris на 15-20% от стока.

реклама

Другие же тестируют просто разные видеокарты, не уравнивая конкурентов в частоте и при этом без зазрения совести называя такие тесты 4 gb vs 8 gb. Чем по моему мнению намеренно вводят покупателя в заблуждение.

Такая модель тестирования началась с RX 400 серии и плавно перекочевала в 500.

Видео чип просто не тянет текстуры, зачем ему много видеопамяти!

реклама

Я компенсирую нехватку видеопамяти оперативной памятью!

По существу: все, что будет затронуто в данной статье, применимо и к другим видеокартам, которые сейчас есть или только появятся на рынке.

Сказ о том, как тестировал я.

Все игры были установлены на SSD, процессор использовался с фиксацией частоты 4250MHz, чтобы буст никак не повлиял на результаты тестирования. Видеокарта Sapphire Radeon RX 570 PULSE ITX 8G, про нее была уже статья. Если кто пропустил. В обоих случаях использовалась одна и та же видеокарта просто с разным БИОС, это позволило избавиться от разных производителей памяти во время тестирования, так как тайминги в разных чипах разные, и они также могли повлиять на производительность пусть и не сильно. Swap фиксирован и установлен на 800mb.

Тест будет на частоте оперативной памяти 3800MHz, но пару игр с наиболее серьезными требованиями к видеопамяти я проведу и на частоте 2133MHz, дабы изучить и влияние частоты оперативной памяти на нехватку видеопамяти. Частично решил отказаться от тестов с встроенными бенчмарками, так как они не всегда точно отображают именно игровой геймплей. Тесты были проведены в разрешении экрана 2560*1080, где использовалось другое разрешение, будет указано. Актуальные настроки графики в играх всегда можно посмотрет в видеоролике.

и следующими показателя производительности памяти.

В ряде игр был тест с памятью на частоте 2133MHz и тайминги 15-15-15-36 CR2.

Как можно увидеть, наблюдается существенное падение производительности оперативной памяти.

Версия ОС: Windows 10 V1909 (December 2019 Update).

Драйвер видеокарты: AMD Radeon Adrenalin Edition 19.12.1 и AMD Radeon Adrenalin Edition 19.12.3 который использовался в первом видео игры Red Dead Redemption 2. Как вам новый драйвер AMD? Оценили авторазгон?

В качестве средств измерения быстродействия применялись утилиты Fraps, MSI Afterburner, HWiNFO64, для построения графиков использовалась программа FLAT.

Результаты тестов: сравнение производительности

Shadow of the Tomb Raider

Чтобы убедиться, что в играх с потреблением видеопамяти менее 4 гигабайт нет разницы между видеокартами, запустим встроенный бенчмарк с настройкой качества текстур на ультра и минимум, все остальные настройки приведены выше.

Как изменится графика от изменения качества текстур, наглядно видно в данном ролике. Вы и сами можете проделать такое, оценивать качество картинки на Youtube такая себе идея конечно.

Assassins Creed Odyssey

У видеокарты с объемом памяти на 4 гигабайта отчетливо видны фризы на графике фреймтайма. И вот тут уже хочется спросить: а стоят ли 3 FPS 30 долларов? Если кто-то не понимает, о чем я сейчас, недавно была публикация одного популярного блогера, кто пропустил, предлагаю ознакомится.

Red Dead Redemption 2

При запуске игры на видеокарте с объемом 4 гигабайта я столкнулся с ограничением по видеопамяти, при первом запуске игры вышло так, что я банально не смог установить свое разрешение экрана 2560*1080 без уменьшения настроек графики, которые были по умолчанию. Игра просто не давала применить настройки.

В итоге видеокарта с объемом видеопамяти 4 гигабайта чуть-чуть мухлевала, назовем это так. И тут вина только видеокарты, ни медленного SSD и загруженного под завязку процессора.

А сейчас бенчмарк с настройками использования видеопамяти 3830Mb и в разрешении 1920*1080. Настройки специально не подбирал, просто выставил так, чтобы уместиться в видеопамять.

Без жульничества снова не обошлось.

Возможно в дальнейших патчах ситуация исправится. В свою очередь новинка отлично идет на видеокартах серии Polaris.

GreedFall

Забегая немного вперед скажу, у видеокарты с объемом 4 гигабайта начались проблемы, степень их серьезности каждый определит для себя сам, как и цену 30 долларов за 3 дополнительных FPS. От себя добавлю, что свести видео оказалось большой проблемой. Всю боль происходящего можно оценить по графику фреймтайма.

График фреймтайма чем-то даже напоминает кардиограмму.

Увидев такое шаткое положение дел у видеокарты на 4 гигабайта, я решил повторить тест с оперативной памятью на частоте 2133MHz. Увы, но свести видео оказалось еще сложнее, лучше не получилось.

Собственно, какие-либо комментарии тут излишни, вы и сами все прекрасно видели.Far Cry 5

Если оперировать значениями из первых двух графиков, то можно предположить, что разницы нет. Вот почему во время тестирования важно указывать такие показатели как 0,1% и 1% FPS.

Forza Horizon 4

Так как мониторинг в данной игре заблокирован, придется довольствоваться малым.

А теперь этот же тест с оперативной памятью на частоте 2133MHz.

В итоге частота оперативной памяти не сильно-то и помогает в играх, при нехватке видеопамяти. Так же владельцам процессоров Zen 2 не стоит сильно гнаться за высокими частотами оперативной памяти, с видеокартами в данной нише.

Продолжаем наш предновогодний тестовый марафон.

Wolfenstein II: The New Colossus

Достаточно интересное и сильное влияние оказало на производительность недостаточное количество видеопамяти.

Battlefield V

Apex Legends

Resident Evil 7 Biohazard

Вот и подошло наше тестирование к концу.

Его смысл заключался в следующем: развеять миф о том, что RX 470/480/570/580 не нужно 8 гигабайт видеопамяти, что чипы «тянут» текстуры, ну и наконец-то сравнить эти видеокарты в одинаковых условиях, ведь такое до сих пор не было сделано должным образом.

Подобная ситуация касается не только видеокарт AMD Polaris, у Nvidia сложилась точно такая же ситуация с GTX 1060 3Gb, сам чип видеокарты еще выглядит вполне пригодным для современных игр, однако нехватка объёма видеопамяти ставит крест на игре с высокими текстурами, в итоге пользователю приходится снижать качество текстур, что на мой взгляд является одним из важнейших параметров игровой графики, которая в свою очередь практически не оказывает влияние на FPS при должном количестве видеопамяти. В ближайшем будущем данные проблемы возникнут и у видеокарт с объемом 6 гигабайт начиная от 1060 6G до 1660Ti, а так же еще не вышедшая RX5600XT с ее 6 гигабайтами. Так что хорошо подумайте при покупке видеокарты в 2020 году. Если во время анонса RX 470/480 в 2016 году (не говорю даже про R290Х и R390/Х) объем 8 гигабайт считался излишеством и ненужным, то уже сейчас в разрешении FullHD является необходимым при определенных настройках.

По данным тестам так же можно определить необходимый объем оперативной памяти для игры в разрешении экрана 1920*1080 и 2560*1080, пока 16 гигабайт вполне достаточно при условии, что у вас не менее 4 гигабайт видеопамяти (во время тестирования в фоне не было никаких лишних программ, типа браузер с открытыми вкладками и мессенжерами связи).

В полной мере компенсировать нехватку видеопамяти у вас не получится даже за счет оперативной памяти на высоких частотах работы.

В свежих играх увы 3-4 гигабайт видеопамяти уже не хватит с приемлемым качеством текстур даже в разрешении 1920*1080, в итоге вам придется любоваться мыльной картинкой и текстурами низкого качества, несмотря на то что производительности самого чипа еще можно сказать достаточно.

Во время очередной перепрошивки видеокарта чуть-чуть пострадала и биос прошился некорректно, пришлось прибегнуть к скрепке и замыканию ног. Не забываем перезагружаться перед прошивкой, а то после нагрузки могут быть вот такие казусы.

Обновлено

Тесты в низком разрешении, качество графики без изменения.

Всех с наступающим новым годом и до новых встреч в следующем году. id3578363

12 мифов о видеокартах, про которые пора забыть

В предыдущих статьях мы поговорили про мифы о процессорах, оперативной памяти и материнских платах, теперь же перейдем к видеокартам, которые уже давно стали обязательной частью любого компьютера.

Первый миф. Чем больше видеопамяти — тем быстрее видеокарта

Казалось бы, это логично — в более мощные видеокарты ставится больше памяти: так, GTX 1070 с 8 ГБ памяти быстрее, чем GTX 1060 с 6 ГБ, а GTX 1080 Ti с 11 ГБ быстрее GTX 1080 с 8 ГБ. Однако следует понимать, что видеопамять, конечно, важна, но зачастую различное ПО не использует всю имеющуюся у видеокарты память: так, в большинстве случаев GTX 1060 с 3 ГБ медленнее версии с 6 ГБ всего на 5-10%, и разница в основном идет из-за различного числа CUDA-ядер.

Но есть производители видеокарт, которые решили воспользоваться этим мифом в свою пользу: так, например, на рынке можно найти GT 740 с 4 ГБ GDDR5 памяти. Казалось бы — да у GTX 780 Ti, топовой видеокарты того поколения, всего 3 ГБ памяти — то есть GT 740, получается, лучше? Разумеется нет — на тех настройках графики, где используется столько памяти, эта видеокарта выдает слайд-шоу. Ну а если снизить уровень графики для повышения «играбельности», то окажется, что использовано от силы 1-2 ГБ памяти. Причем такие видеокарты встречаются и в текущих линейках — так, у AMD есть RX 550 с теми же 4 ГБ GDDR5 — с учетом того, что видеокарта выступает приблизительно на уровне GT 1030, очевидно, что использовать столько памяти она сможет в очень немногих задачах:

Так что не стоит судить о производительности видеокарты, опираясь только на объем видеопамяти.

Второй миф. Если видеокарте не хватит видеопамяти в игре, то обязательно будут фризы, вылеты и тому подобное

Опять же, это кажется логичным: если видеокарте памяти не хватило, взять ее больше неоткуда — значит, программы корректно работать не смогут. Однако на деле это, разумеется, не так — любая видеокарта имеет доступ к оперативной памяти, которой обычно куда больше, чем видеопамяти. Конечно, ОЗУ в разы медленнее, а время доступа к ней больше — это может вызвать проблемы с плавностью картинки, но только лишь в том случае, если собственной памяти видеокарте не хватает сильно: например, у нее 2-3 ГБ памяти, а игра требует 4-5 ГБ. Но если не хватает нескольких сотен мегабайт, то обычно это проблем не вызывает: GPU умеют динамически использовать доступные им ресурсы, и в ОЗУ они стараются хранить ту информацию, которая нужна редко или не требует мгновенного отклика.

Третий миф. От разгона видеокарты сгорают

При этом различные производители продают разогнанные с завода версии видеокарт. Разумеется, при разгоне видеокарта может повредиться — но только в том случае, если вы измените «физические» параметры, такие как напряжение. Изменение программных параметров, таких как частоты, никак на «железо» не влияет, так что максимум, что вы получите, это вылет видеодрайвера или BSOD от выставления слишком высокой частоты.

Четвертый миф. SLI/Crossfire увеличивают производительность и объем видеопамяти во столько раз, сколько видеокарт подключено

Насчет производительности это, скорее, не миф, а теоретический результат. Увы — на практике, хотя тому же SLI 20 лет, а Nvidia его использует больше 10 лет, в большинстве игр прирост или околонулевой, или вообще отрицательный. Лишь в единичных проектах можно получить прирост хотя бы 20-30% в сравнении с одной видеокартой, что, конечно, смешно, с учетом двукратного увеличения стоимости и серьезных требований к блоку питания. Что касается вычислительных задач, то тут все сложнее: так, профессиональный софт вполне может использовать несколько GPU эффективно, но это уже не домашнее применение.

Что касается видеопамяти, то тут все просто: при использовании DirectX 11 или ниже в видеопамять каждого используемого GPU записывается одинаковая информация, то есть у связки видеокарт будет по сути тот же объем памяти, что и у одиночной карты. А вот в API DirectX 12 есть возможность более эффективно использовать Split Frame Rendering, когда каждая видеокарта готовит свою часть кадра. В таком случае объемы видеопамяти суммируются — пусть и с оговорками.

Пятый миф. Профессиональные видеокарты лучше игровых

Миф идет от того, что профессиональные видеокарты (такие как Nvidia Quadro или AMD FirePro) стоят обычно сильно дороже пользовательских «игровых» видеокарт — а раз дороже, значит лучше. На практике вопрос только в том — в какой области лучше? С физической точки зрения большая часть профессиональных видеокарт имеют тот же GPU и тот же объем памяти, что и обычные игровые видеокарты, а разница идет только из-за других драйверов, которые больше заточены под профессиональное применение:

С учетом того, что эти драйвера под игры никто специально не адаптирует, то профессиональные видеокарты в играх зачастую будут несколько хуже аналогичных по производительности игровых GPU. С другой стороны, если мы будем сравнивать эти же видеокарты в различных CAD-ах или 3ds Max — перевес будет на стороне профессиональной графики, причем зачастую очень существенный. Так что ответ на миф таков: сравнивать эти видеокарты в лоб не имеет смысла, они «играют» и в разных ценовых сегментах, и в разных сценариях использования.

Шестой миф. Если видеокарта не раскрывается процессором — это плохо

Пожалуй, самый популярный миф, который гласит о том, что если видеокарта не занята на 100% — это плохо. С одной стороны, это кажется логичным: нагрузка ниже 100% означает, что видеокарта частично простаивает и вы недополучаете часть производительности. С другой стороны, многие забывают, что нагрузить GPU на 100% можно практически при любом процессоре. Как так? Очень просто: каждый процессор в каждой игре может подготовить для видеокарты лишь определенное количество кадров в секунду, и чем процессор мощнее — тем больше кадров он может подготовить. Соответственно, чтобы видеокарта была занята на 100%, она должна иметь возможность отрисовать меньше кадров в секунду, чем может дать ей процессор. Как это сделать? Да очень просто: поднять разрешение, поставить более высокие настройки графики, включить тяжелое сглаживание — и вуаля, GTX 1080 Ti в 5К на ультра-настройках графики «пыхтит», выдавая 15-20 кадров в секунду, а поставленный ей в пару двухядерный Intel Pentium едва ли нагружен на половину.

Легко можно получить и обратную ситуацию: взять ту же самую GTX 1080 Ti и запустить на ней игру в HD-разрешении с минимальными настройками графики — и тут даже Core i9-9900K не сможет подготовить для ней столько кадров в секунду, чтобы она была занята на 100%.

Так что тут можно сделать два вывода: во-первых, если видеокарта недогружена несильно, а итоговый fps вас устраивает — всегда можно еще немного увеличить настройки графики, чтобы получить 100% нагрузку на видеокарту с лучшей картинкой и при той же производительности. Во-вторых, собирайте сбалансированные сборки, дабы не было такого, что процессор занят на 100%, а fps в игре 20 кадров.

Седьмой миф. Чем уже шина памяти — тем ниже производительность видеокарты

Очень часто на различных форумах можно встретить посты типа «вот, 8 лет назад у GTX 480 шина памяти была 384 бита, а сейчас у GTX 1080 всего 256, Nvidia экономит». Опять кажется, что это логично — чем шире шина, тем больше данных по ней можно «гонять». Но тут следует помнить две вещи: во-первых, не шиной единой: частоты памяти с того времени выросли в разы, во-вторых — производители GPU постоянно улучшают алгоритмы передачи данных по шине, что позволяет использовать ее более эффективно. Все это приводит к тому, что ширину шины можно безболезненно урезать: так, MX150 (она же GT 1030), имея шину всего в 64 бита (как один канал ОЗУ), способна при этом выдавать производительность уровня GTX 950M со 128-битной шиной, которая еще пару-тройку лет назад считалась среднеуровневой мобильной игровой видеокартой:

Восьмой миф. Если видеокарта не перегревается, то она работает на максимально возможной для нее частоте в рамках ее теплопакета

Увы — аналогия с процессорами тут не работает: если те действительно удерживают максимальные частоты в рамках TDP вплоть до температуры, с которой начинается троттлинг из-за перегрева, то видеокарты работают хитрее: так, у Nvidia есть технология GPU Boost, которая, с одной стороны, является аналогом Turbo Boost для процессоров — позволяет поднимать частоту выше базовой — а с другой стороны имеет больше ограничений.

Возьмем, для примера, GTX 1080 Ti. Она имеет родную частоту в 1480 МГц, а Boost — 1580. Но стоит нагрузить видеокарту, как частота может подскочить до 1800-1850 МГц — то есть выше Boost: это и есть работа технологии GPU Boost. Дальше — интереснее: критические температуры у видеокарт поколения Pascal составляют порядка 95 градусов — но уже при 85 можно заметить, что частоты снижаются ближе к уровню Boost. Почему так? Потому что Nvidia ввела еще одну опорную температуру, которую называет целевой: при ее достижении видеокарта старается ее не превышать, а для этого сбрасывает частоты. Так что если у вас мощная видеокарта, да и еще с референсным турбинным охлаждением — внимательно следите за температурами, ибо от них в прямом смысле зависит производительность.

Девятый миф. Видеокарты без дополнительного питания хуже аналогов с ним

В продаже можно встретить видеокарты уровня GTX 1050, 1050 Ti и AMD RX 550 без дополнительного питания — то есть, как в старые добрые времена, достаточно поставить их в слот PCIe и они готовы к работе. При этом также есть версии 1050 и 1050 Ti с дополнительным питанием 6 pin, из-за чего некоторые пользователи делают вывод, что раз дополнительное питание есть — значит с ним видеокарты будут работать лучше.

На деле это не совсем так: слот PCIe способен дать видеокарте до 75 Вт, и этого вполне хватает, чтобы даже 1050 Ti работала на указанных на официальном сайте Nvidia частотах. Но если вы нацелены на разгон — да, тут питания от PCIe видеокарте может уже не хватить, так что дополнительные 6 pin от блока питания позволят достичь больших частот, однако разница в любом случае не превысит 10%.

Десятый миф. Не стоит ставить современные PCIe 3.0 видеокарты на старые платы со слотами PCIe 2.0 или 1.0

Все опять же логично — так, пропускная способность PCIe 2.0 x16 вдвое ниже, чем у 3.0 x16, а, значит, современные видеокарты через более старую шину PCIe будут работать медленнее. На деле это опять же не так — пропускная способность PCI Express 3.0 x16 даже для топовых современных видеокарт оказывается избыточной:

Хорошо видно, что разница между 3.0 x16 и 2.0 x16 составляет всего 1%, то есть погрешность, и даже если спуститься до PCIe 1.1 — то есть к материнским платам почти десятилетней давности — падение производительности оказывается всего лишь 6%. Так что вердикт тут прост — версия PCIe практически не влияет на производительность видеокарты, соответственно можно смело к Xeon с PCI Express 2.0 брать GTX 1080.

Одиннадцатый миф. Разгон видеопамяти не имеет смысла

Конечно, наибольший прирост дает разгон ядра видеокарты — тут прирост производительности близок к линейному (то есть увеличили частоту на 10% — получили прирост производительности на 10%). Однако не стоит сбрасывать со счетов видеопамять, особенно в слабых видеокартах: зачастую в них ставят те же чипы памяти, что и в более мощные решения, но при этом сильно снижают частоту. Это дает возможность ее достаточно сильно разогнать, зачастую на 20-40%, что может прибавить к общей производительности графики еще 10-15% — для слабых видеокарт это лишним, разумеется, не будет:

Двенадцатый миф. С выходом каждой новой линейки видеокарт производители урезают производительность старой

Достаточно популярный миф, основанный обычно на том, что на одних (обычно более старых) версиях драйверов видеокарта работает лучше, чем на других (обычно более новых). Разумеется, никакого реального основания он не имеет: если бы Nvidia и AMD на самом деле хотели заставить пользователей обновить видеокарты, они бы прекращали их поддержку как производители смартфонов на Android, через пару лет после выхода. Однако на деле даже решения 600-ой линейки от Nvidia, вышедшей более 6 лет назад, до сих пор получают новые драйвера наравне с более новыми видеокартами, причем со всеми программными «плюшками» типа DirectX 12.

Но почему тогда есть разница в производительности между драйверами? Потому что ничто в нашем мире не идеально, и какие-то драйвера, улучшая производительность в новых играх, могут испортить производительность в более старых или привести к различным ошибкам. Обычно через некоторые время выходят исправленные драйвера, и все возвращается на круги своя.

Если вы знаете еще какие-либо мифы — делитесь ими в комментариях.

Ещё один миф. С выходом новой линейки видеокарт, старые дешевеют. Нвидиа это успешно опровергала, просто накрутив цену на новые карты))

Соответственно, чтобы видеокарта была занята на 100%, она должна иметь возможность отрисовать меньше кадров в секунду, чем может дать ей процессор. Как это сделать? Да очень просто: поднять разрешение, поставить более высокие настройки графики, включить тяжелое сглаживание — и вуаля, GTX 1080 Ti в 5К на ультра-настройках графики «пыхтит», выдавая 15-20 кадров в секунду, а поставленный ей в пару двухядерный Intel Pentium едва ли нагружен на половину.

А может быть, ВНЕЗАПНО, стоит поставить более быстрый процессор, и FPS будет выше за счёт простаивавших мощностей GPU?

Более половины всех мифов правда.

Второй миф. Если видеокарте не хватит видеопамяти в игре, то обязательно будут фризы, вылеты и тому подобное

Фризы тебе точно гарантированы,и естественно это не миф,попробуй запустить RE7 или Rise of the Tomb Raider с максимальными текстурами на видяхе с 4 гагами памяти,и получишь гарантированные фризы,собственно это мои случаи когда у меня ещё была GTX980,стоило снизить текстуры на один пункт и фризы естественно прекращались.

saa0891 DDR4 более чем достаточно, чтобы по крайней мере не было фризов, так что если не хватает VRAM можно просто добавить воды. gennaz Eh. Евгений Кондратенко Да лучше уж 970 по дешевке ищет и не будет парится в новых игорях.

бестолковые блоги для получения бонусов

Еще один миф. С выходом новой линейки старые должны дешеветь. Это широко распространенный миф. Ибо рынок живет по другим законам. Если конкуренты не могу предоставить даже на старую линейку достойной конкуренции. С чего это новая линейка более быстрая должна быть по той же цене что и старая. И уж тем более еще более быстрые карты должны быть по аналогичной цене старой линейки аналогов конкурента. Проще говоря если бы АМД представяла конкурирующие решения на старую линейку то новая линейка Нвидиа была бы дешевле. А так скажите спасибо АМД за ее технологическую импотенцию.

Однако на деле даже решения 600-ой линейки от Nvidia, вышедшей более 6 лет назад, до сих пор получают новые драйвера наравне с более новыми видеокартами Перед тем,как писать данную статью,автору стоило бы зайти на сайт нвидиа и убедиться,что сейчас поддерживаются видеокарты от 700 серии и выше.

gennaz Чувак, помоему это следовало сделать тебе, прежде, чем писать эту дичь.

Евгений Кондратенко Хм, думаешь я не посмотрел,прежде чем писать?))) Это «поддержка» только на бумаге,а на деле вот так

gennaz Т.е. ты запустил на gt630 новую ларку и ждёшь 60фпс в 4к? А если нет то это драйвера плохие? Ты вообще адекватный.

gennaz Чувак, не страдай фигней и не выставляй себя дураком. Купи себе на авито хотя бы GTX 770 и будешь нормально играть. Такие карты стоят на авито 6000-7000р, зато на них не будет такого ахтунга, как у тебя на скриншоте. Да и сама по себе 770 отличная карточка, всё-таки предтоповая семисотка.

erkins007 Дело не в низком фпс,а в графических артефактах в этой игре на карте 600 серии.Евгений Кондратенко Сам себе купи такое фуфло! Да и достаточно было заглянуть в профиль,чтобы не предлагать покупать всякое старьё,у меня любые игры идут отлично, на достаточно приличных настройках.