Медиаскоп что за опрос

Как мы проводим исследования

Часто задаваемые вопросы:

Большинство опросов населения проводятся через центр телефонных опросов компании-партнера ЗАО «ТНС МИЦ». Филиалы расположены в городах Тула и Санкт-Петербург. С помощью нашего трекера ниже вы можете проверить, что вам действительно звонили мы.

Если Вы не запомнили номер, но хотели бы проверить факт звонка из нашей компании, направьте заявку на адрес team@mediascope.net с указанием номера телефона и города Вашего проживания, на который поступил звонок, примерного времени звонка, тематики и, по возможности, других деталей разговора.

Для всех опросов телефоны генерируются случайным образом: первые три цифры – это префикс сотового оператора, начинающийся с 9 (или местная АТС для фиксированных номеров), а остальные – генератор случайных чисел. Компьютерная программа, позволяющая создавать совершенно случайный набор чисел. Сгенерированные таким образом телефоны, добавляются в опросы, и по этим телефонам мы звоним Вам и проводим опросы на различные тематики.

В рамках некоторых проектов Медиаскоп предоставляется информация не только об объемах аудитории СМИ или количеству пользователей товаров/услуг, но и о социально-демографическом профиле аудитории, который включает информацию о поле и возрасте аудитории, уровне образования, достатка, стиле жизни и т.д.

У разных групп населения потребительское поведение и предпочтения разные, ответы позволяют лучше понять респондентов и учесть их потребности и ожидания. По этой причине в анкетах включены вопросы, косвенным образом касающиеся уровня достатка, а также владения личным автотранспортом и другим имуществом

В рамках некоторых проектов Медиаскоп присутствует метод формализованного интервью – это форма контакта с респондентом, когда строго обязательным является соблюдение точности формулировок и последовательности задания вопросов.

Любое отклонение от сценария интервью отражается на качестве собранных данных.

Если вы по какой-либо причине не желаете участвовать в телефонных опросах, Вы можете выслать заявку с просьбой исключить номер Вашего телефона из базы номеров Mediascope (с обязательным указанием номеров, которые необходимо исключить). Заявки принимаются на электронный адрес team@mediascope.net

С политикой АО «Медиаскоп» в сфере защиты персональных данных вы можете ознакомиться здесь.

С политикой АО «ЭДФАКТ» в сфере защиты персональных данных Вы можете ознакомиться здесь.

В случае, если у Вас возникнут дополнительные вопросы, Вы можете отправить их на адрес электронной почты наших компаний (АО «Медиаскоп») и (АО «Эдфакт»)

Эрнст сравнил анализ Mediascope с пилотированием по сломанным приборам

Гендиректор «Первого канала» Константин Эрнст считает, что анализировать аудиторию телеканалов на основе данных компании Mediascope «так же опасно, как летчику пилотировать самолет по сломанным приборам».

Эту компанию Роскомнадзор в октябре утвердил как единого измерителя телеаудитории в 2019 году (срок контракта — три года), Mediascope устанавливает в домохозяйствах специальные приборы — пиплметры — которые измеряют, какие каналы и в какое время смотрят россияне. Такие пиплметры установлены в 7,8 тыс. домохозяйств по всей России, однако измерения обнародуют пока только с 5,8 тыс. приборов, установленных в городах с населением более 100 тыс. человек.

РБК приводит полностью мнение гендиректора «Первого канала» об исследованиях Mediascope:

«В 2020 году со всеми его стримами, платформами и интернет-вещанием, со всем многообразием медиапотребления странно само по себе существование измерений, проводимых с помощью железных коробочек. В широком кругу мало кто знает, а в узком мало кто задумывается, что обладатель коробочки, так называемый панелист, должен при каждом включении телевизора регистрироваться на специальном пульте, жать на кнопку, выходя покурить, снова жать, вернувшись обратно. Должен регистрировать всех членов семьи, приходящих и уходящих от телевизора, и так ежедневно, годами и с абсолютно не ясной для себя целью (мы, конечно, понимаем, где именно обладатели коробочек видели все эти требования). И уж точно мало кто представляет, что доли и рейтинги больших каналов, например в Москве (городе с 13-миллионным населением), часто распределяются на основании данных порядка 30 таких коробочек, так что победу того или иного канала явно определяет бабушка, в чью-то пользу заснувшая у телевизора. К сожалению, большую часть производителей телевизионного контента эти данные вынуждают ориентироваться на пожилых, не выходящих из дома женщин, отгоняя все другие возрастные и социальные группы от классического телевидения. Анализировать аудиторию на основании этих данных так же опасно, как летчику пилотировать самолет по сломанным приборам. В 2020 году, когда телевидение потребляется в значительной степени не через телевизор, обсуждение среднесуточной доли по железным коробочкам может увлекать только тех, кто своим годовым бонусом интересуется больше, чем зрителями».

РБК направил запрос в Mediascope.

Как ссорились и мирились Эрнст и Mediascope

«Первый канал» вновь начал пользоваться услугами Mediascope только в 2017 году, в то время как другие федеральные телеканалы сотрудничали с Mediascope (ранее работала под брендом TNS) с 1989 года, когда компания вышла на российский рынок. «Первый» отказался от услуг TNS в 2005 году, Константин Эрнст неоднократно критиковал TNS, называя методику телеизмерителя устаревшей. Спустя 12 лет канал все же договорился с измерителем о сотрудничестве и стал клиентом Mediascope. Но несмотря на возобновление сотрудничества, глава «Первого канала» продолжил выступать с публичной критикой в адрес измерителя. Так, в сентябре 2020 года на профильной конференции TV2B он отметил, что система Mediascope «измеряет только сегмент аудитории — в основном пожилой, малоподвижной и не очень состоятельной».

Константин Эрнст раскритиковал систему Mediascope после вопроса РБК — удовлетворен ли «Первый канал» своими результатами по доле телеаудитории в январе—ноябре 2020 года, которую подсчитал измеритель. Согласно этим данным, «Первый канал» уже пятый год подряд уступает телеканалу «Россия 1» звание самого популярного у телезрителей вещателя. Впервые флагманский канал ВГТРК обогнал «Первый» по среднесуточной доле аудитории среди всех жителей крупных городов старше четырех лет еще в 2016 году, тогда доли каналов равнялись 12,9 и 12,7% соответственно. В следующие три года разрыв увеличился, а уже в январе— ноябре 2020 года среднесуточные доли «России 1» и «Первого» составили 12,5 и 10,6%.

Данные, которые предоставляет Mediascope, напрямую влияют на доходы телеканалов. Среднесуточная доля, которую измеряет компания, отражает популярность канала, и от этого зависят его продажи рекламы: чем больше зрителей смотрят канал и, соответственно, рекламные блоки, тем больше продажи в натуральном выражении. Реклама на ТВ продается по так называемым пунктам рейтинга, которые отражают количество зрителей, увидевших стандартный рекламный ролик (раньше за основу брался 30-секундный ролик, с 2020-го — уже 20-секундный). В 2020 году В январе—октябре 2020 года «Первый канал» предложил рекламодателям 135,3 тыс. таких пунктов рейтинга в своей целевой аудитории — на 1% меньше, чем годом ранее, «Россия 1» предложила до 215,2 тыс. пунктов рейтинга, что на 2% больше результатов 2019 года.

Технологии

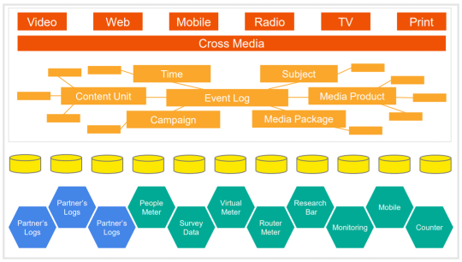

Панельные исследования – основа измерений Mediascope. Панельные данные дают представление о поведении человека в медиа, социально-демографическом профиле аудитории, контентных предпочтениях и других важных параметрах, которые необходимы клиентам компании для операционной работы и стратегического планирования коммуникаций.

Телевизионная панель Mediascope насчитывает более 20 тысяч человек по всей России и репрезентирует всё население страны старше 4 лет – по своему размеру ТВ-панель компании занимает пятое место в мире. В домах и на дачах участников телевизионного исследования установлены специальные устройства – ТВ-метры, которые в автоматическом режиме собирают информацию о просмотре телевизора. Контент и реклама, которые увидели респонденты, распознаются с помощью технологии audio matching, которую используют ТВ-метры.

В интернет-измерениях Mediascope использует две панели: десктопную – более 15 тыс. респондентов, и мобильную – более 14 тыс. респондентов. Они репрезентируют всё население России старше 12 лет. Данные о посещении интернет-ресурсов собираются с помощью специальных измерительных инструментов, установленных на устройствах участников панели. Для десктопных устройств это специальная надстройка в браузерах, для смартфонов и планшетов – измерительное приложение. Информация об аудитории также собирается с помощью счетчиков компании, которые размещают на своих ресурсах интернет-площадки.

В интернет-измерениях Mediascope также использует внешние данные от партнеров – это полностью анонимизированные сведения об активности на площадках, которые предоставляют интернет-компании. Эта информация обрабатывается совместно с данными наших интернет-панелей.

В некоторых проектах Mediascope используются single-source панели – они состоят из респондентов, которые одновременно участвуют в нескольких исследованиях: ТВ и интернет-измерениях. Такие панели применяются, например, в проекте Big TV Rating – исследовании потребления телеконтента и рекламы сразу в нескольких средах: в линейном эфире и на десктопных устройствах в интернете. Данные для таких проектов собираются, в том числе, с помощью роутер-метров. Это специальные устройства, которые помогают анализировать медиапотребление на всех устройствах в домохозяйстве, которые подключены к интернету.

Наряду с собственными разработками Mediascope использует в измерениях различные решения технологических партнеров. В 2020 году компания заключила две стратегические сделки с российскими вендорами технологий для сбора и обработки данных о медиапотреблении – компаниями Cifrasoft и MediaHills. В апреле 2021 года Mediascope заключила соглашение о стратегическом партнерстве с компанией AdMetrix – российским поставщиком данных мониторинга out-of-home рекламы.

MediaHills – поставщик решений для обработки и анализа технологических данных о медиапотреблении, которые собираются в сетях телеком-операторов. Компания анализирует данные о телепросмотре, полученные по обратному каналу связи телевизионных приставок операторов платного ТВ – Return-Path-Data (RPD). MediaHills выступает точкой сбора таких данных для Mediascope. Компания также разрабатывает рекомендательные системы и консалтинговые решения для операторов платного ТВ.

AdMetrix — поставщик данных мониторинга наружной рекламы и аудиторных данных, специалист по работе с картами, геоинформационными системами и различного рода данными, на основе которых рассчитываются аудиторные характеристики рекламных конструкций и рекламных кампаний в сегменте out-of-home. Продуктами компании являются также оценка эффективности рекламы посредством опросов респондентов и аудит размещения.

Mediascope Data Platform

В 2020 году Mediascope запустила собственную платформу для работы с данными, в которой собираются и обрабатываются большие массивы разнородных данных о контакте человека с медиа и рекламой, потребительском поведении, включая данные партнеров.

Mediascope Data Platform – это не только технологическая платформа, но и новая модель работы с данными для всей рекламной индустрии. При создании платформы Mediascope ориентировалась не только на собственные задачи по обработке и анализу данных, но, в первую очередь, на индустриальную потребность в инструментах для работы с постоянно растущим объемом разнородных данных и их источников.

Все данные в платформе приводятся к единой структуре – event-логу, который в унифицированном виде описывает контакт с медиа и рекламой – кто увидел контент или рекламу, что именно увидел, когда и где. Слой агрегированных «сырых» данных хранится в платформе в виде дата-сетов, с которыми клиенты компании могут работать в принципиально новом для компании рабочем пространстве DataLab.

Mediascope Data Platform построена на стеке open-source технологий, которые доступны и понятны профессиональным участникам медиа-рекламного рынка. Технологическая основа платформы – экосистема Hadoop, но для работы с данными также используются другие инструменты стриминговой обработки, потоковых вычислений и self-service аналитики.

DataLab – это рабочее пространство для самостоятельного анализ данных, которые хранятся в Mediascope Data Platform. C помощью DataLab клиенты компании получают быстрый доступ к слою «сырых» данных и могут извлечь ценность углубленной и расширенной аналитики для своего бизнеса

В DataLab аналитики данных и data science специалисты могут искать инсайты о поведении аудитории, тестировать маркетинговые гипотезы и продуктовые идеи, создавать новые алгоритмические решения для повышения эффективности бизнеса и рекламных коммуникаций.

Пользователи DataLab могут самостоятельно использовать математические инструменты для обработки «сырых» данных, которые реализованы в платформе как self-service. Mediascope выделяет клиентам необходимое количество мощности облачных вычислений для работы в DataLab, предоставляет полный набор описательной документации о преобразовании данных и работе алгоритмических расчетов, а также, при необходимости, сопровождает экспериментальные проекты клиентов.

Работать с данными Mediascope можно несколькими способами:

Как организована работа с данными в Mediascope

В конце декабря мы в GeekBrains провели совместный с Mediascope митап. Mediascope — лидер российского рынка медиаисследований, мониторинга рекламы и СМИ. Это компания, которая обрабатывает огромный объём информации. В своём выступлении директор по работе с большими данными Василий Кузьмин рассказал, как сейчас в Mediascope организована эта работа. Текстовая версия выступления — в этой статье.

Концепция

Когда я пришёл в Mediascope, перед нами стояла задача разработать платформу для обработки данных, которая будет соответствовать более высоким требованиям по сравнению со старыми системами.

Mediascope собирает данные из разных источников: их десятки, они разнородные по объему и качеству информации. Из одного идут миллионы записей в день, из другого данные поступают раз в полгода. Данные приходят как из источников внутри компании, так и с устройств, которые Mediascope раздаёт респондентам. А ещё их предоставляют партнёры — крупные рекламные и интернет-холдинги, медиа. Они зачастую являются и потребителями нашей аналитики, и поставщиками сырых данных.

Старое решение было построено по тоннельному принципу: для каждого источника создавался отдельный канал со своими системами. Новая платформа должна была решить две задачи:

Мы спроектировали новую платформу в классической манере — использовали не только мой опыт, но вообще все лучшие подходы, которые есть на рынке. Не то чтобы это были революционные решения — напротив, всё опробованное и достаточно консервативное. Я бы охарактеризовал это как «топ минус один». Большие данные — сравнительно молодая отрасль. Топовые подходы ещё слишком свежи, а потому ненадежны. Мы же должны были построить платформу со сверхвысокой надежностью. Поэтому использовали проверенное поколение технологий, которые тем не менее в топе.

Мы сделали масштабируемую платформу и собрали единую точку входа. Общая концепция устроена так же, как и в 70% успешных проектов. В её основе — канонический подход со стороны архитектуры. Если вы посмотрите, как это реализовано в крупных компаниях, с большой долей вероятности это будет нечто похожее. Во-первых, потому что одни и те же архитекторы курсируют из компании в компанию. Во-вторых, потому что это правда работает.

Поэтому наша концепция достаточно универсальна.

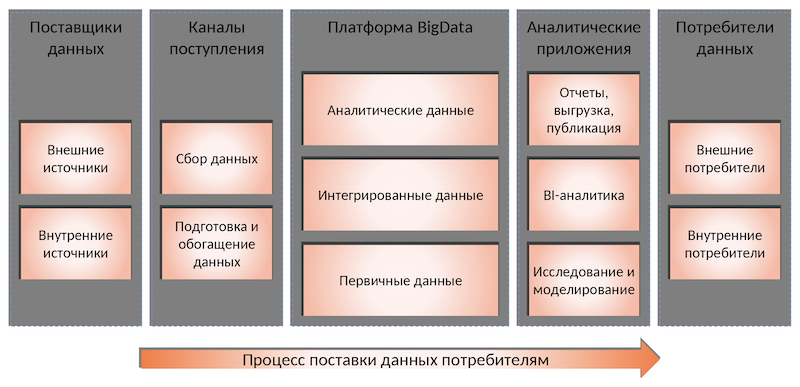

Поставщики данных

Всегда есть поставщики данных — наши собственные источники и сторонние. Собственные данные мы можем более тщательнее проверить, если видим, что данные некачественные. А информацию из внешних источников мы принимаем как есть. Именно поэтому важно уметь работать с данными разного качества.

Каналы поступления данных

Мы используем Apache NiFi — оркестровщик потоков данных, который отвечает за то, чтобы каждую систему в нужный момент дёрнуть, получить от неё данные и положить на вход в нашу платформу. В качестве транспорта между NiFi и платформой используется Kafka.

Платформа Big Data

Сама платформа — это кластер Hadoop. Сейчас там около 50 дата-узлов, но и его уже надо расширять. Сейчас мы с этим кластером переехали в облако — используем, кстати, SberCloud. Здесь есть несколько слоёв. Они каноничны с точки зрения не только Hadoop, но и классического подхода к данным.

К первичным данным есть доступ только у программистов, дата-инженеров. Это технический уровень, который мы не показываем даже внутренним пользователям. К двум другим уровням имеют доступ наши клиенты, хоть и с ограничениями. Но важно, что наш API начинается со слоя интегрированных данных. Мы изначально строили структуру так, чтобы эти уровни не стыдно было кому-то показать.

Аналитические приложения

Это программы, сервисы и службы, которые используют данные и что-то с ними делают. Условно их можно разделить их на три основные группы:

Потребители данных

Это приложения, которые непосредственно платформу не видят, но смотрят на неё через призму аналитических приложений.

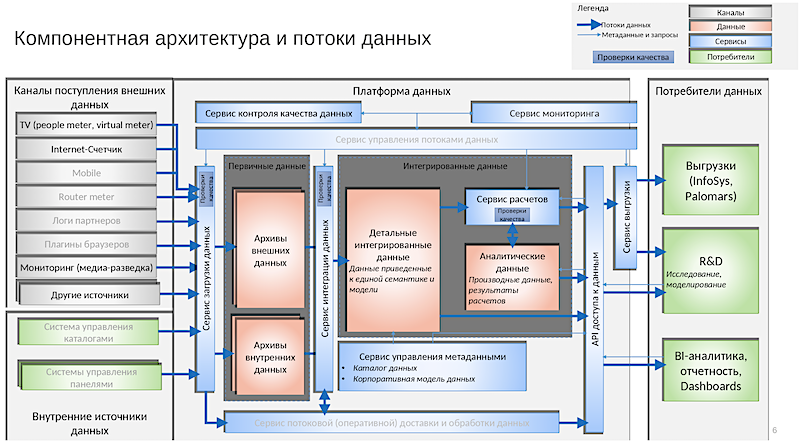

Архитектура

Если смотреть на платформу с точки зрения архитектуры, она выглядит примерно так. Это картинка годичной давности. То, что есть сейчас, на слайд уже не уместится. Так реализована концепция, которую я описал.

Из примечательного здесь:

Сервисы

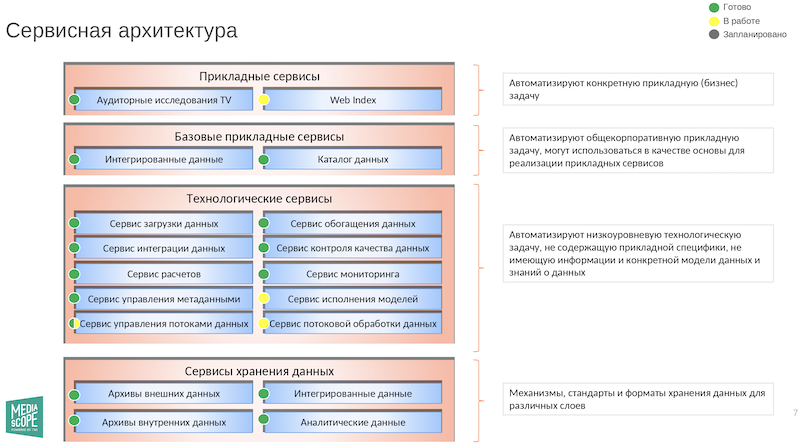

А вот схема сервисов:

Из интересных сервисов:

Инструменты работы с данными платформы

Мы реализовали три варианта подключения к данным. Первый — через Spark. Это для продвинутых пользователей, которые знакомы с Zeppelin или Jupyter. Можно также подключиться к большому хранилищу данных — например, тот же Tableau может построить дашборд. Наконец, можно работать непосредственно с Hadoop как с файлами — это самый низкоуровневый доступ.

Требования к дата-специалистам

У проджект-менеджеров есть PMBoK — документ, в котором содержатся стандартизированные требования к управлению проектами. Для дата-специалистов тоже есть подобное издание под названием DAMA. Там, помимо прочего, содержится набор ролей, которые бывают при работе с данными.

От начинающих специалистов обычно требуют как минимум знания SQL. Это будет первый вопрос на собеседовании. Я ещё обычно смотрю на университет, потому что качество образования везде разное. Также имеет значение, есть ли в резюме дополнительные курсы, готов ли человек вкладываться в образование временем и деньгами. Понятно, что от начинающего сразу много требовать не будут, ему дадут время на обучение. Так что будьте готовы учиться и читать документацию, это очень важно.

Освоить востребованную профессию в Data Science можно всего за полтора года на курсах GeekBrains. После учёбы вы сможете работать по специальностям Data Scientist, Data Analyst, Machine Learning, Engineer Computer Vision-специалист или NLP-специалист.

Освоить востребованную профессию в Аналитике больших данных можно всего за полтора года на курсах GeekBrains.

В конце декабря мы в GeekBrains провели совместный с Mediascope митап. Mediascope — лидер российского рынка медиаисследований, мониторинга рекламы и СМИ. Это компания, которая обрабатывает огромный объём информации. В своём выступлении директор по работе с большими данными Василий Кузьмин рассказал, как сейчас в Mediascope организована эта работа. Текстовая версия выступления — в этой статье.

Концепция

Когда я пришёл в Mediascope, перед нами стояла задача разработать платформу для обработки данных, которая будет соответствовать более высоким требованиям по сравнению со старыми системами.

Mediascope собирает данные из разных источников: их десятки, они разнородные по объему и качеству информации. Из одного идут миллионы записей в день, из другого данные поступают раз в полгода. Данные приходят как из источников внутри компании, так и с устройств, которые Mediascope раздаёт респондентам. А ещё их предоставляют партнёры — крупные рекламные и интернет-холдинги, медиа. Они зачастую являются и потребителями нашей аналитики, и поставщиками сырых данных.

Старое решение было построено по тоннельному принципу: для каждого источника создавался отдельный канал со своими системами. Новая платформа должна была решить две задачи:

Мы спроектировали новую платформу в классической манере — использовали не только мой опыт, но вообще все лучшие подходы, которые есть на рынке. Не то чтобы это были революционные решения — напротив, всё опробованное и достаточно консервативное. Я бы охарактеризовал это как «топ минус один». Большие данные — сравнительно молодая отрасль. Топовые подходы ещё слишком свежи, а потому ненадежны. Мы же должны были построить платформу со сверхвысокой надежностью. Поэтому использовали проверенное поколение технологий, которые тем не менее в топе.

Мы сделали масштабируемую платформу и собрали единую точку входа. Общая концепция устроена так же, как и в 70% успешных проектов. В её основе — канонический подход со стороны архитектуры. Если вы посмотрите, как это реализовано в крупных компаниях, с большой долей вероятности это будет нечто похожее. Во-первых, потому что одни и те же архитекторы курсируют из компании в компанию. Во-вторых, потому что это правда работает.

Поэтому наша концепция достаточно универсальна.

Поставщики данных

Всегда есть поставщики данных — наши собственные источники и сторонние. Собственные данные мы можем более тщательнее проверить, если видим, что данные некачественные. А информацию из внешних источников мы принимаем как есть. Именно поэтому важно уметь работать с данными разного качества.

Каналы поступления данных

Мы используем Apache NiFi — оркестровщик потоков данных, который отвечает за то, чтобы каждую систему в нужный момент дёрнуть, получить от неё данные и положить на вход в нашу платформу. В качестве транспорта между NiFi и платформой используется Kafka.

Платформа Big Data

Сама платформа — это кластер Hadoop. Сейчас там около 50 дата-узлов, но и его уже надо расширять. Сейчас мы с этим кластером переехали в облако — используем, кстати, SberCloud. Здесь есть несколько слоёв. Они каноничны с точки зрения не только Hadoop, но и классического подхода к данным.

К первичным данным есть доступ только у программистов, дата-инженеров. Это технический уровень, который мы не показываем даже внутренним пользователям. К двум другим уровням имеют доступ наши клиенты, хоть и с ограничениями. Но важно, что наш API начинается со слоя интегрированных данных. Мы изначально строили структуру так, чтобы эти уровни не стыдно было кому-то показать.

Аналитические приложения

Это программы, сервисы и службы, которые используют данные и что-то с ними делают. Условно их можно разделить их на три основные группы:

Потребители данных

Это приложения, которые непосредственно платформу не видят, но смотрят на неё через призму аналитических приложений.

Архитектура

Если смотреть на платформу с точки зрения архитектуры, она выглядит примерно так. Это картинка годичной давности. То, что есть сейчас, на слайд уже не уместится. Так реализована концепция, которую я описал.

Из примечательного здесь:

Сервисы

А вот схема сервисов:

Из интересных сервисов:

Инструменты работы с данными платформы

Мы реализовали три варианта подключения к данным. Первый — через Spark. Это для продвинутых пользователей, которые знакомы с Zeppelin или Jupyter. Можно также подключиться к большому хранилищу данных — например, тот же Tableau может построить дашборд. Наконец, можно работать непосредственно с Hadoop как с файлами — это самый низкоуровневый доступ.

Требования к дата-специалистам

У проджект-менеджеров есть PMBoK — документ, в котором содержатся стандартизированные требования к управлению проектами. Для дата-специалистов тоже есть подобное издание под названием DAMA. Там, помимо прочего, содержится набор ролей, которые бывают при работе с данными.

От начинающих специалистов обычно требуют как минимум знания SQL. Это будет первый вопрос на собеседовании. Я ещё обычно смотрю на университет, потому что качество образования везде разное. Также имеет значение, есть ли в резюме дополнительные курсы, готов ли человек вкладываться в образование временем и деньгами. Понятно, что от начинающего сразу много требовать не будут, ему дадут время на обучение. Так что будьте готовы учиться и читать документацию, это очень важно.

Освоить востребованную профессию в Data Science можно всего за полтора года на курсах GeekBrains. После учёбы вы сможете работать по специальностям Data Scientist, Data Analyst, Machine Learning, Engineer Computer Vision-специалист или NLP-специалист.

Освоить востребованную профессию в Аналитике больших данных можно всего за полтора года на курсах GeekBrains.