На чем основано действие поисковых систем

Поисковые системы стали частью нашей повседневной жизни. В месяц только лишь с одного Гугла делают более 100 миллиардов запросов. Это сумасшедшие цифры, учитывая, что существуют множество других более мелких поисковиков, ну а в россии, более половины всех запросов приходится на Яндекс.

Конечно, в этом нет ничего сверхестественного, так-как ежедневно, с помощью поисковиков люди ищут различную информацию, покупают товары, выбирают выгодный кредит и ипотеку, заказывают пиццу, продвигают бизнес и т.д. Впрочем вся онлайн жизнь человека во многом зависит от них, так-как именно эти сервисы ведут нас на нужный нам сайт.

Однако давайте все по-порядку и в этом видео вы узнаете историю и как работают поисковые системы, какие вообще бывают поисковики, сколько они зарабатывают и много другое, поэтому обязательно ставьте лайк этому видео и подписывайтесь на наш канал, так, вы стимулируете нас, к созданию нового интересного контента.

Краткая история поисковых систем

Давайте начнем с краткой историей поисковиков.

Основные этапы развития поисковых систем приходятся на период с 1993 по 1998 год.

В 1993 году был создан первый поисковик в той форме которую мы знаем сегодня. Он носил название Wandex, а разработал его молодой парень по имени Мэттью Грей. Wandex сканировала сайты и искала поисковый запрос, по заголовкам страниц сайтов в интернете.

В 1994 году, основанный на технологии Wandex, поисковик WebCrawler, начал индексировать не только заголовки, ну и полный текст сайтов. Это позволило поисковику давать больше более точных результатов по запросу.

Система Yahoo, была основана в 1994 году и одним из ее крупнейших вкладов в интернет-поиск стала служба каталогов, состоящая из большой коллекции авторитетных сайтов.

В этом же году был создан поисковик Lycos, который обрел большую популярность и многие веб-мастера, добавляли свои сайты в каталог данного сервиса.

Однако все же переломный момент произошел в декабре 1995 году, когда была создана полноценная поисковая система AltaVista. Поисковик использовал 20 многопроцессорных серверов, и все они были поддержаны, самой мощной на тот момент вычислительной системой. Это была самая быстрая поисковая система, которая могла обрабатывать миллионы поисковых запросов в день.

Важным нововведением AltaVista было включение поиска естественного языка, это означало, что пользователи могли напечатать любую фразу или вопрос и получить на нее интеллектуальный ответ.

Еще не менее переломным моментом был 1996 год, когда студенты Стэнфордского университета Ларри Пейдж и Сергей Брин, решили что поисковые системы должны анализировать сайты в зависимости от того, сколько раз слова, используемые при поиске, появлялись на веб-страницах. Благодаря этому, они создали новый алгоритм под названием PageRank.

Вслед, а именно в 1998 году, вместе с полнофункциональным поисковиком появилась и сама компания Google.

Новая поисковая система, просто разнесла в хлам всех своих конкурентов и в 2002 году Google занял лидирующее положение на рынке. Начиная с 2004 года доля Google на рынке неуклонно растет, а компания ежегодно расширяется и выдает новые продукты.

Ну а компания Яндекс была основана в 2000 году и благодаря инновациям в искусственном интеллекте, Яндекс может легко работать с российской терминологией при поиске на зарубежных ресурсах, благодаря чему в отдельных нишах обгоняет зарубежные технологии.

Принцип работы поисковиков

Главная цель любого современного поисковика, это выдать максимально релевантный и полезный для пользователя поисковый результат, а в частности, сайт, в котором пользователь сможет найти нужную ему информацию или воспользоваться нужной ему услугой. Принцип работы всех поисковых систем почти одинаковый, а проходит он в 3 основных этапа: сканирование, индексирование, показ результатов поиска.

Сканирования

На этапе сканирования, специальный алгоритм изучает весь контент в интернете и пытается найти новый сайт или уже обновленный контент, а также добавить его в индекс Google. Индекс это по сути самая важная составляющая любого современного поисковика, однако о нем мы поговорим чуть позже.

Для того, чтобы отсканировать миллиарды страниц, так-как именно столько алгоритм и обрабатывает, у Google, есть программа, которая собственно и выполняет сканирование и называется она googlebot, если бот нашел новый контент, то дальше сканирует его для обнаружения ссылок ведущих на другой веб-сайт. И скажем по принципу “паутины”, он обнаруживает множество ссылающихся на друг друга веб-сайтов. Тем ни менее, бот не посещает абсолютно каждый сайт. Чтобы попасть в список проверяемых, веб-ресурс должен быть рассмотрен, как достаточно важный.

Также, в сканирование могут попасть сайты, которые зарегистрировались через специальный сервис для веб-мастеров под название Google Search Console. С помощью него владельцы веб-сайтов, могут отслеживать эффективность страниц, поисковых запросов и т.д.

Индексирование

При индексировании алгоритм пытается определить тематику сайта, какой у него контент и вообще есть ли запрещающий контент, а также алгоритм умеет распознавать текст и медиафайлы находящиеся на страницы. В процессе, специальный алгоритм под названием Panda, сканирует веб-страницу на наличие оригинального авторского контента, и в случае обнаружение, он дает страницы высокий рейтинг, если же контент скопирован или имеет множество материалов, которые нарушают авторские права, то соответственно рейтинг страницы снижают.

Одним словом, при индексировании, алгоритм проводит полный анализ контента содержащийся на сайте, а также помимо основного, существует множество и других алгоритмов, например алгоритм Penguin, который обнаруживает спам, алгоритм Page Layout, который проверят, используется ли

на сайте слишком много агрессивной рекламы или алгоритм Hummingbird, который нужен чтобы максимально точно понимать запрос пользователя, например когда вы пишите слово “погода”, чтобы не выдавалось определение термина, а показывался прогноз погоды.

Именно на этом этапе строится вся поисковая база, а именно индекс, о котором мы говорили ранее. Индекс это база данных, в котором хранится весь контент веб-сайтов. Именно сюда ссылается google, когда в очередной раз принял поисковый запрос от пользователя. То есть когда пользователь вводит “Как защитить конфиденциальность в интернете”, система анализирует всю индексную базу, которая состоит из несколько миллионов серверов по всему миру, и опираясь на него, находит наиболее релевантный источник.

Вообще. для того чтобы эффективно хранить информацию о миллиардах страниц в базе данных поисковой системы, Google использует крупные центры обработки данных в Европе, Азии, Северной и Южной Америке.

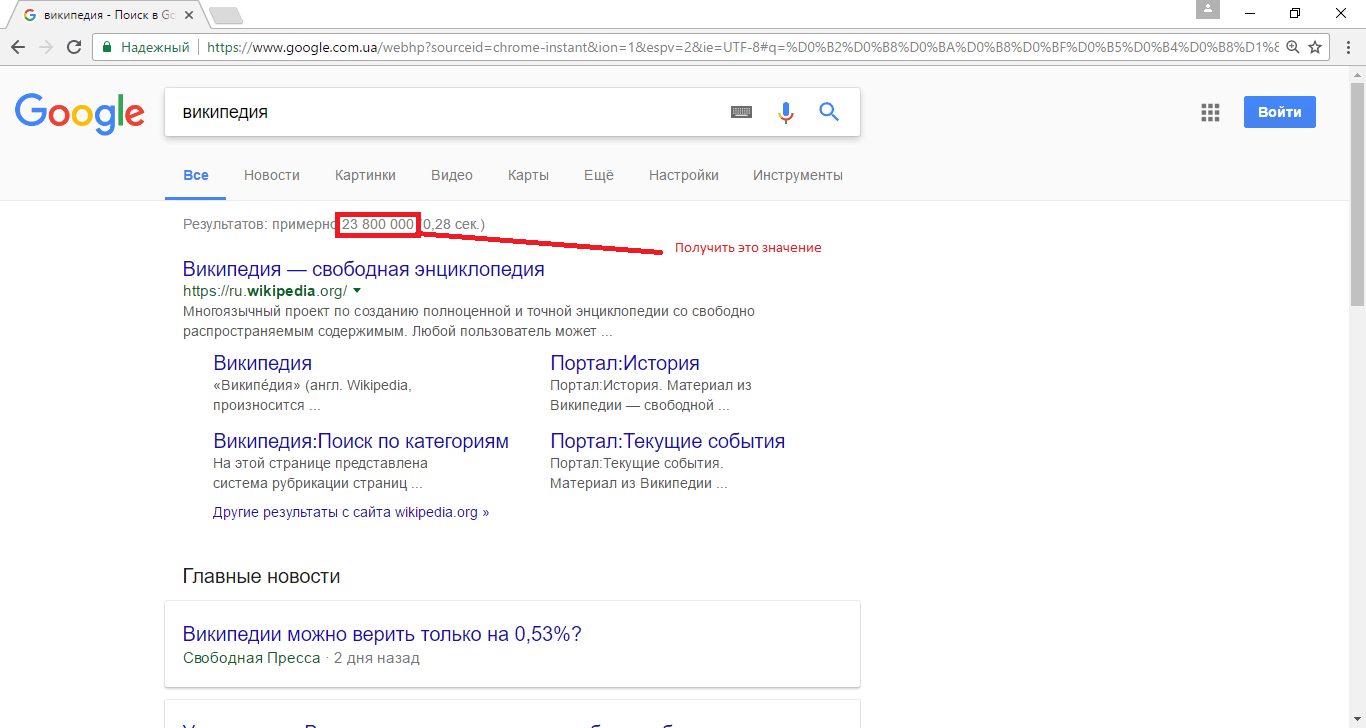

Показ результатов поиска

Как я уже говорил, когда пользователь вводит поисковый запрос, Google в своем индексе, опираясь при этом на самые разные факторы (а их на секунду более 200 штук), далее ищет наиболее подходящие результаты. К таким факторам относятся местоположение, язык, тип устройства пользователя (компьютер или телефон) и т. д.

Например, результаты по запросу «ремонт велосипедов» будут различаться в зависимости от того, находитесь вы в Москве или в Киеве. Ранжирование выполняется естественно по алгоритмам Google, и компания, никак не повышает рейтинг страниц за плату.

Результаты, которые считаются более релевантными для пользователя, намеренно получают более высокий ранг, чем результаты, которые имеют меньше шансов обеспечить адекватный ответ.

Заключение

Все 3 этапа, а именно сканирование, индексирование и показ результатов происходит не тогда, когда пользователь ввел запрос. Такая система была бы не совсем корректной, так-как поисковик, долго выдавал бы ответ, всего лишь на 1 запрос пользователя. Ну а основная задача любой поисковой системы, это дать моментальный результат.

Например 1 этап, а именно сканирование, происходит безостановочно. То есть бот работает бесперебойно 24/7, чтобы найти как можно больше источников или обнаружить обновление контента в уже найденных страницах.

Этап индексирования происходит после того, как бот добавил страницу в очередь на обработку контента. При этом в работу вступают другие алгоритмы проверки, которые я приводил ранее.

Этап показ результатов поиска происходит соответственно когда пользователь ввел поисковый запрос. При этом специальный алгоритм пытается понять запрос, не на основе ключевых слов, а на основе естественного языка. То есть чтобы когда пользователь вводил слово пицца, ему предлагались различные магазины, где они смогут его заказать.

Какие существуют поисковики помимо Google

Немногие знают, что помимо привычных Google и Яндекса, существуют и другие поисковики.

Например популярный yahoo, который славится новостными статьями в финансовом секторе, занимает около 2% всего рынка.

Поисковик от компании Microsoft под названием Bing, занимает около 3%.

На 3 месте по популярности идет поисковик Яндекс. Учитывая, что он занимает больше половины рынка в россии и определенную часть в странах СНГ, на мировом рынке он занимает около 1%.

Далее идет китайский поисковик Baidu, который также является монополистом на своем рынке. Как и Яндекс, он занимает около 1% всего рынка.

Также есть и более конфиденциальный поисковик под названием DuckDuckGo. Он не собирает персонализированную информацию о пользователе и является относительно безопасным вариантом для тех, кто не хочет, чтобы следили за его историей поиска.

Из таких интересных также могу выделить поисковик Ask.com. Он был создан в 1996 году и основным фокусом является поиск ответов на вопросы.

На отечественном рынке и вообще в СНГ, также существуют такие поисковики как Поиск mail.ru, который в последнее время, за счет изменения алгоритмов, улучшил выдачу поисковых ответов и Рамблер, который по большей части является каталогом и медийно-сервисным интернет порталом.

Как и сколько зарабатывают поисковики

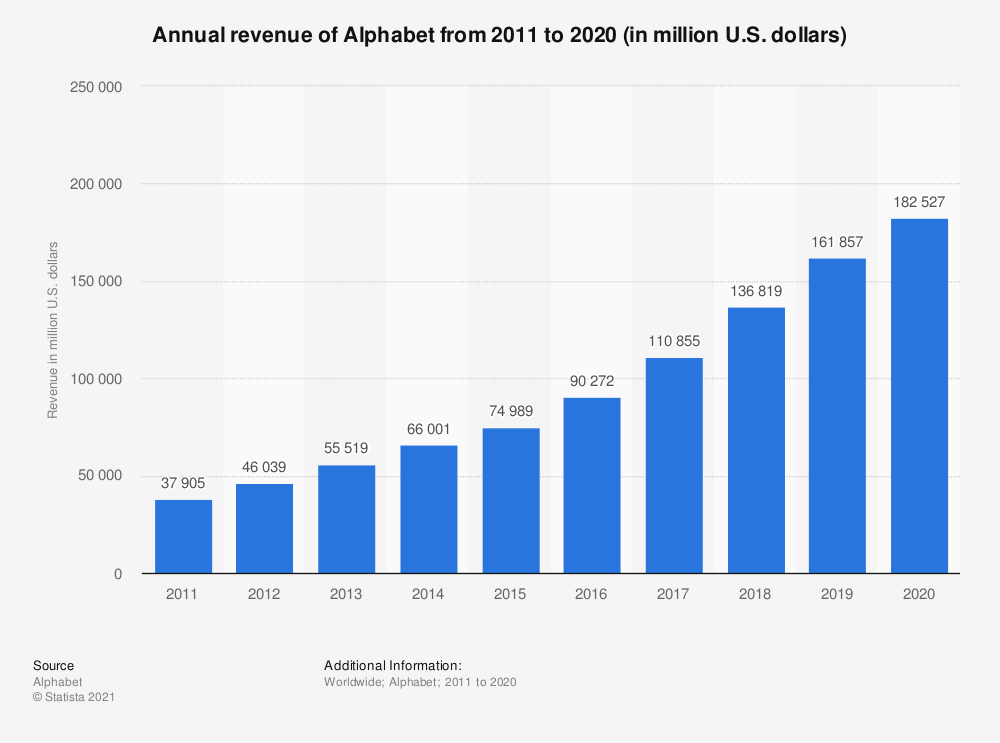

Сегодня Google, это уже не просто поисковик, а универсальная технологическая компания, которая работает в широком сегменте рынка IT. Поэтому, существуют и другие источники дохода, а именно лицензионные сборы операционной системы Android, облачные сервисы Google Cloud, продажа смартфонов Google Pixel и т.д.

Также есть и множество онлайн сервисов от Google, некоторые из которых в определенной степени монетизируются тем-самым принося прибыль.

Основной доход компании, идет с рекламных интеграций на множестве площадках, например через поисковик, яндекс дзен и яндекс эфир. Однако за последний год, ввиду пандемии и всей этой истории с короновирусом, рекламные компании, намного сократились, а вот довольно таки успешный сервис яндекс такси, приносит неплохую, стабильную прибыль компании.

Заключение

Чтобы объяснить как работают поисковые системы, одного видео конечно же мало. Однако я попытался быстро и максимально просто объяснить основные базовые принципы работы поисковиков. Поэтому, если вам понравился ролик и вы хотите увидет множество подобного контента, то обязательно ставьте лайк этому видео и подписывайтесь на канал. Также не забывайте делиться своим мнением в комментариях. Ну а я как всегда не прощаюсь.

Принципы работы поисковых систем

Порядка 95% интересующей пользователя информации в интернете он находит в поисковых сервисах, Google, Yandex, Bing, Yahoo, DuckDuckGo и т.д (Смотрите — Рейтинг поисковых систем интернета). Но сам сайт, где вводится запрос — это лишь обертка, под которой скрывается сложный программно-аппаратный комплекс, анализирующий миллиарды сайтов ежедневно и составляющий на их основе базы данных. В статье я расскажу, как работают алгоритмы поисковых систем, как именно идет поиск и ранжирование нужной информации и почему мы так быстро получаем ответ на свои запросы.

Работа поисковых систем

Условно считается, что история создания поисковых систем берет свое начало с 1989 года. Именно тогда был создан сервис Арчи, главная задача которого была индексация информации, которую можно найти в интернете (в пространстве WWW). Система изобретена и создана программистом Аланом Эмтеджем. И алгоритмы, которые он в ней использовал, в базовом понимании используются и по сегодняшний день. Правда, данный сервис был локальным.

А уже в 1996 году была создана программа BackRub. Её главное преимущество — она выполняет глобальную индексацию. Уже в 1998 году система будет переименована в Google. А сейчас это — самый популярный сервис в мире для поиска информации в интернете (по данным аналитиков, его использует порядка 85% всех интернет-пользователей).

Общий принцип работы любой поисковой системы условно можно разделить на следующие этапы:

Описанный принцип работы информационно поисковых систем — это лишь условное пояснение, как работает тот же Google или Яндекс. Но вот алгоритмы, которые они используют для обхода, сайтов, индексации и ранжирования, обычным пользователям неизвестны, каждая поисковая система применяет свои алгоритмы и постоянно их совершенствует, так как обработка информации занимает большое количество ресурсов сервера, расходы на который лежат на поисковой системе.

Понятно лишь одно — каждый сайт анализируется по более чем 1000 критериев. И именно благодаря этому пользователь, отправивший поисковый запрос, в 99% случаев в ответ получает ссылку, на страницу с полезной информацией.

Поисковые системы бывают нескольких подвидов и существуют и другие вариации таких сервисов:

И многие рядовые пользователи ошибочно полагают, что особенности работы поисковых систем таковы, что поиск оптимальных результатов для выдачи выполняется в режиме реального времени. Нет, выполнить анализ значительной части веб-пространства за несколько секунд — невозможно. Даже суперкомпьютерам для этого понадобится несколько месяцев, а то и лет. Поэтому без предварительной обработки информации, и постоянного ранжирования не обойтись.

Общие принципы обработки информации

Каждый этап, описанный выше, выполняется отдельной программой (или их комбинациями). Это — так называемые «составляющие» алгоритмов поисковых систем.

Spider

Робот закачивающий веб страницы на сервер, он скачивает интернет-сайт, что в дальнейшем будет проиндексирован. Причем, загружает он все страницы и готовит полученные данные для анализа следующей программой. Если пользователя на загружаемом сайте интересует только контент (текст, картинки, мультимедиа), то spider работает именно с исходным кодом и html документами.

Crawler

Данная программа автоматически открывает и анализирует все ссылки, которые ей удается найти на сайте (в архиве, предварительно подготовленном с помощью Spyder (Паука). Это позволяет в дальнейшем составить «дерево» адресов, а также обнаружить точные ссылки, которые будут предоставляться в ответ на поисковые запросы. Кстати, если Crawler встречает «битую» ссылку — это затрудняет его работу, и соответственно заставляет поисковик тратить больше бюджета на индексирование Вашего сайта.

Indexer

Программа которая проводит индексацию, всех полученных данных от Spider и Crawler. То есть делит загруженную страницу на составные части (по html-тегам) и формирует список данных, которые здесь представлены.

Database

На основе информации, полученной после индексации, формируются 2 раздельные базы данных. Первая — это «дерево» сайта с его мета-тегами. В дальнейшем она используется при выполнении повторной индексации. То есть вместо того, чтобы повторно изучать сайт, выполняется сверка «деревьев» — так поисковый сервис определяет, вносились ли какие-то изменения на анализируемый веб-ресурс.

Вторая база данных — это результаты индексации. Та самая информация, на основе которой определяется условный рейтинг сайта, а также составляется перечень поисковых запросов, в ответ на которые можно предоставить ссылку.

Search Engine Results Engine

Web server

Сервер, на котором хранится сайт поискового сервиса. Именно его открывает пользователь, там же он вводит свой запрос и просматривает результаты выдачи.

Принципы работы поисковой системы

Главные этапы составления базы данных для поисковых сервисов — это индексация и ранжирование сайтов. И чтобы результативность итоговой выдачи была точной, сейчас применяется схема машинного обучения. То есть поисковику демонстрируют для сравнения 2 противоположных результата и указывают, по какой схеме необходимо выполнять их ранжирование. Таким образом система понимает, какой сайт «полезный», какой — «менее полезный».

Всё это позволяет вывести отдельный индекс — релевантность (условно можно назвать «рейтингом»). Он присваивается каждому сайту, представлен в виде дробного числа. Чем выше релевантность — тем выше будет позиция ресурса в выдаче на запрос пользователя. Это — основные принципы работы поисковых систем, используемых сегодня. И этот процесс тоже состоит из нескольких этапов.

Сбор данных

После создания сайта и получения на него ссылки, система автоматически анализирует его с помощью инструментов Spyder и Crawling. Информация собирается и систематизируется из каждой страницы.

Индексация

Индексация выполняется с определенной периодичностью. И по её прохождению сайт добавляется в общий каталог поисковой системы. Результата этого процесса — создание файла индекса, который используется для быстрого нахождения запрашиваемой информации на ресурсе.

Обработка информации

Система получает пользовательский запрос, анализирует его. Определяются ключевые слова, которые в дальнейшем и используются для поиска по файлам индекса. Из базы данных извлекаются все документы, схожие на пользовательский запрос.

Ранжирование

Из всех документов, отобранных для выдачи, составляется список, где каждому сайту отведена своя позиция. Выполняется на основании ранее вычисленных показателей релевантности.

На этом этапе принцип работы поисковых систем немного разнится. Формула ранжирования — тоже уникальная. Но ключевые факторы, влияющие на релевантность сайта, следующие:

СПРАВКА! Если вам необходимо заказать продвижение сайта в поисковых системах, я могу Вам помочь, сделать качественный SEO аудит сайта и составить план продвижения.

Основные характеристики поисковых систем

Главный параметр — это наглядность. То есть насколько точная информация представлена в выдаче на усмотрение самого пользователя, который и отправлял запрос. Но есть и другие характеристики для оценки поисковых систем.

Полнота

Условный параметр, который указывает соотношение от общего числа документов, дающих ответ на пользовательский запрос, от их количества, представленного системой в выдаче. Чем выше соотношение — тем более полный анализ производится сервисом.

Точность

Можно описать на примере. Пользователь ввёл запрос «купить квартиру». В выдаче было представлена 1000 сайтов. Но в половине из них просто встречается данное словосочетание. В другой части — предлагаются ресурсы, где можно совершить покупку недвижимости. Естественно, что пользователя интересуют последние. В данном случае точность работы поискового сервиса составляет 0,5 (то есть 50%). Чем выше показатель — тем больше точность.

Актуальность

Имеется ввиду время, прошедшее с момента публикации данных на сайте до его добавления в каталог индексации. Чем быстрее этот процесс будет завершен, тем более актуальную информацию пользователю представят в выдаче. Для современных сервисов, типа Bing или Google периодичность обновления базы данных индексации составляет до 3-х месяцев. Для релевантных сайтов — несколько дней.

Скорость поиска

Она же — «устойчивость к нагрузкам». Определяется временем, необходимым для составления списка сайтов для выдачи после получения пользовательского запроса. По большей части зависит только от производительности серверов, обрабатывающих данные, а также общего количества получаемых запросов. Современные сервисы могут обрабатывать одновременно до 100 миллионов таковых ежесекундно.

Наглядность

Пользовательская оценка в работе сервиса. Во многом зависит от того, какие ссылки рядовой пользователь увидит в ТОП выдачи. Ведь именно их он изучает в первую очередь. И полученная на них информация должна на 100% ответить на его запросы.

Выводы

Постоянная индексация и ранжирование — это основной принцип работы поисковых интернет систем. А за написание алгоритмов и программ, которые выполняют большую часть всей этой работы, отвечают тысячи программистов. Именно благодаря их работе каждый пользователь за несколько секунд может отыскать в веб-пространстве необходимую для него прямо сейчас информацию.

Если Вам понравилась статья поделитесь ей в социальных сетях, так же рекомендую прочитать статью — методах продвижения сайта в интернете.

Если вы хотите более глубоко понимать принцип работы поисковых систем рекомендую посмотреть видео от Сергея Кокшарова и почитать его SEO блог

Работа поисковых систем: общие принципы работы поисковиков

Вступление

Каждая поисковая система имеет свой алгоритм поиска запрашиваемой пользователем информации. Алгоритмы эти сложные и чаще держатся в секрете. Однако общий принцип работы поисковых систем можно считать одинаковым. Любой поисковик:

Работа поисковых систем – общие принципы

Вся работа поисковых систем выполняют специальные программы и комбинации этих программ.

Перечислим основные составляющие алгоритмов поисковых систем:

Реализация механизмов поиска у поисковиков может быть самая различная. Например, комбинация программ Spider+ Crawler+ Indexer может быть создана, как единая программа, скачивающая и анализирующая веб-страницы и находящая новые ресурсы по найденным ссылкам. Тем не менее, нижеупомянутые общие черты программ присущи всем поисковым системам.

Программы поисковых систем

Spider

«Паук» скачивает веб-страницы так же как пользовательский браузер. Отличие в том, что браузер отображает содержащуюся на странице текстовую, графическую или иную информацию, а паук работает с html-текстом страницы напрямую, у него нет визуальных компонент. Именно, поэтому нужно обращать внимание на ошибки в html кодах страниц сайта.

Crawler

Программа Crawler, выделяет все находящиеся на странице ссылки. Задача программы вычислить, куда должен дальше направиться паук, исходя из заданного заранее, адресного списка или идти по ссылках на странице. Краулер «видит» и следует по всем ссылкам, найденным на странице и ищет новые документы, которые поисковая система, пока еще не знает. Именно, поэтому, нужно удалять или исправлять битые ссылки на страниц сайта и следить за качеством ссылок сайта.

Indexer

Программа Indexer (индексатор) делит страницу на составные части, далее анализирует каждую часть в отдельности. Выделению и анализу подвергаются заголовки, абзацы, текст, специальные служебные html-теги, стилевые и структурные особенности текстов, и другие элементы страницы. Именно, поэтому, нужно выделять заголовки страниц и разделов мета тегами (h1-h4,h5,h6), а абзацы заключать в теги

Database

База данных поисковых систем хранит все скачанные и анализируемые поисковой системой данные. В базе данных поисковиков хранятся все скачанные страницы и страницы, перенесенные в поисковой индекс. В любом инструменте веб мастеров каждого поисковика, вы можете видеть и найденные страницы и страницы в поиске.

Search Engine Results Engine

Search Engine Results Engine это инструмент (программа) выстраивающая страницы соответствующие поисковому запросу по их значимости (ранжирование страниц). Именно эта программа выбирает страницы, удовлетворяющие запросу пользователя, и определяет порядок их сортировки. Инструментом выстраивания страниц называется алгоритм ранжирования системы поиска.

Важно! Оптимизатор сайта, желая улучшить позиции ресурса в выдаче, взаимодействует как раз с этим компонентом поисковой системы. В дальнейшем все факторы, которые влияют на ранжирование результатов, мы обязательно рассмотрим подробно.

Web server

Web server поисковика это html страница с формой поиска и визуальной выдачей результатов поиска.

Повторимся. Работа поисковых систем основана на работе специальных программ. Программы могут объединяться, компоноваться, но общий принцип работы всех поисковых систем остается одинаковым: сбор страниц сайтов, их индексирование, выдача страниц по результатам запроса и ранжирование выданных страниц по их значимости. Алгоритм значимости у каждого поисковика свой.